هدف اصلی از سئو این است که محتوای شما توسط موتورهای جستجو ایندکس شده و از رتبه خوبی برخوردار شود. اما دلایل موجهی وجود دارد که ادمینها از گوگل درخواست میکنند تا برخی از صفحات توسط خزندهها ایندکس نشود. خوشبختانه مکانیزمی وجود دارد که به عنوان استاندارد حذف رباتها شناخته میشود و به شما کمک میکند محتوای موتورهای جستجو را مسدود کرده و حذف یک صفحه را از نتایج گوگل به راحتی امکانپذیر میسازد.

روشهای مختلفی برای مسدود کردن دسترسی ربات گوگل به یک صفحه یا حذف صفحات ایندکس شده وجود دارد؛ اما اینکه از کدام یک استفاده کنید به نوع محتوایی که باید حذف شود و هدف از حذف آن بستگی خواهد داشت.

دلایل برای پاک کردن صفحات ایندکس شده در گوگل

وقتی عمر زیادی از یک سایت میگذرد و مطالب زیادی در طول سالیان متمادی در آن منتشر شده، به دلیل زیاد شدن تعداد صفحات بیهدف (بدون کلیدواژه) مثل صفحات آزمایشی، صفحات تشکر که بعد از تکمیل فرم یا خرید برای مشتری باز میشوند و… رنکینگ سایت تحت تأثیر قرار بگیرد. چراکه در این حالت تمام URLهای ایجاد شده دیگر مفید نخواهند بود و درصدی از آنها را URLهای بیهدف تشکیل خواهند داد.

اگر جلوی رشد افسارگسیخته سایت خود را نگیرید و به خزندههای گوگل اجازه خزیدن همه صفحات وبسایتتان را بدهید، از آنجا که صفحات بیارزش از اعتبار کلی سایت کم میکنند، نمیتوانید به رتبهای که شایسته سایت شماست برسید. ضمن اینکه بودجه خزش شما هم خیلی زود تمام میشود.

بیشتر بخوانید: انتقال دامنه سایت

اکنون ببینیم چه صفحاتی فاقد ارزش محسوب شده و نباید در صفحات SERP ایندکس شوند.

ایندکس شدن صفحات غیر مرتبط

برخی از قالبهای وردپرس هنگام نصب اولیه روی وب سایت، مجموعهای از صفحات آماده را برای ادمینها فراهم میکنند. این صفحات نمونه با محتوای از پیش تعریف شده در اختیار صاحب سایت قرار میگیرد تا بتواند ذهنیتی از شکل ظاهری سایت و نمایش محتوا داشته باشد. همچنین میتواند این صفحات را ویرایش کرده و صفحاتی مطابق با سلیقه شخصی خودش ایجاد کند. اغلب اوقات ادمینهای سایت فراموش میکنند که باید این صفحات را قبل از ایندکس شدن سایت حذف کنند.

اگر این اتفاق رخ دهد، باعث کاهش رتبه سئو به دلیل کپی و بیارزش بودن محتوای صفحات و احتمالا زبان متفاوت میشود. در این مرحله وبمسترها باید اقدام به حذف این گونه صفحات کنند تا از افت رتبه سایت جلوگیری شود.

ایندکس شدن صفحات با محتوای ضعیف

صفحات ایندکس شده با کیفیت پایین نیز میتوانند به سئو سایت آسیب برسانند. وقتی گوگل صفحات زیادی با محتوای بسیار کم پیدا کند، مجازاتهایی برای مقابله اعمال میکند که معمولا منجر به کاهش رتبه سایت میشود. به همین دلیل باید این قبیل صفحات را از گوگل حذف کنید.

به طور کلی به صفحات با کمتر از ۳۰۰ کلمه، دارای محتوای تکراری و… صفحات زامبی میگویند. این صفحات معمولاً دارای مشکلات فنی مانند لود شدن طولانی مدت بوده یا اسکریپتهایی هستند که اجرا نمیشوند. اگر گوگل محتوای شما را تکراری ببیند، ممکن است محتوا را بخزد اما آن را در فهرست قرار ندهد. گوگل این کار را برای جلوگیری از تکراری شدن SERP انجام میدهد. با حذف محتوای تکراری از فهرست، گوگل قادر خواهد بود صفحات منحصر به فرد بیشتری در اختیار کاربران قرار دهد و آنها را راضی نگه دارد.

این مسئله به ویژه در بسیاری از سایتهای فروشگاهی دارای اولویت بالایی است. صفحات مهم این قبیل سایتها مانند صفحات توصیف محصول، اغلب دارای محتوای یکسانی با دیگر فروشگاههایی است که همین محصول را عرضه میکنند. اگر گوگل این قانون را نداشت ممکن بود همه آنها را از فهرست حذف کند.

در مواردی غیر از این میتوانید برای جلوگیری از بروز این وضعیت از تگ کنونیکال (canonical) برای این قبیل صفحات استفاده کرده و به این وسیله به جای صفحه بیارزش و کم محتوا، یک صفحه مرتبط اما با ارزشتر را به گوگل معرفی کنید.

بیشتر بخوانید: تگ کنونیکال چیست؟ کاربرد تگ canonical در سئو

حذف صفحه از خود سایت

اگر میخواهید صفحه به طور کلی هم از صفحات نتایج گوگل و هم از خود سایتتان ناپدید شود، ابتدا باید صفحه را از سرور وب حذف کرده و سپس با استفاده از ابزار حذفی که گوگل در اختیار مدیران سایتها قرار داده به حذف کامل آن از صفحات SERP اقدام کنید.

صفحات ایجاد شده در اثر هک شدن وبسایت

گاهی ممکن است بعد از هک شدن و برگرداندن سایتتان متوجه شوید هکرها تعداد زیادی صفحه بیارزش روی سایت ایجاد کردهاند. این صفحات علاوه بر اینکه تجربه کاربری بدی برای کاربرانتان به وجود میآورند، با فهرست شدن در صفحات SERP به رتبه کلی سایت شما لطمه وارد کرده و اعتبار برندتان را تحت تأثیر قرار میدهند.

صفحه حاوی اطلاعات خصوصی

مواردی وجود دارد که خزندههای گوگل به محتوایی دسترسی پیدا میکنند که نباید به آنها دسترسی داشته باشند. اگر محتوای یک صفحه خاص خصوصی باشد، ممکن است نخواهید که این صفحه توسط موتورهای جستجو فهرست شود. به طور کلی، محتوای مسدود شده در موتورهای جستجو فقط برای افرادی در دسترس است که شما خودتان مجوز دسترسی را برایشان صادر کرده باشید.

دقت داشته باشید که مسدود کردن دسترسی رباتها برای ایندکس نشدن یک صفحه توسط موتورهای جستجو به این معنی نیست که دیگر خزندهها و رباتها نمیتوانند محتوای آن صفحات به خصوص را بخوانند بلکه فقط آن را ایندکس نمیکنند. بنابراین اگر محتوا حساس و محرمانه است، نباید فقط به مسدود کردن دسترسی رباتها اکتفا کرد، بلکه لازم است تا با استفاده از طرح احراز هویت از بازدیدکنندگان غیرمجاز جلوگیری شود.

بیشتر بخوانید: آموزش ثبت لوکیشن در گوگل مپ

روشهای حذف urlهای ایندکس شده از گوگل

مکانیسمهای زیادی وجود دارد که میتوانید صفحات ناخواسته را از ایندکس موتور جستجو خارج کنید. هرکدام هم موافقان و مخالفان خاص خود را دارند. در ادامه به محبوبترین روشهای حذف URLهای ایندکس شده از گوگل اشاره خواهیم کرد.

حذف یا به روز کردن محتوا

اگر صفحه را حذف کنید و کد وضعیت ۴۰۴ (یافت نشد) یا ۴۱۰ (از بین رفته) را به کاربران نشان دهید، اندکی پس از خزیدن دوباره، صفحه موردنظر از ایندکس حذف خواهد شد.

مشکل این روش این است که این احتمال وجود دارد تا صفحه موردنظرتان برای مدتی در نتایج جستجو نشان داده شود و تا حذف شدن کامل آن اندکی زمان ببرد. در این صورت یا کاربران با خطای ۴۰۴ یا ۴۱۰ مواجه میشوند یا یک نسخه کش از صفحه برایشان نمایش داده خواهد شد.

Noindex کردن صفحه

یکی از موثرترین و آسانترین ابزار برای پاک کردن صفحه index شده، استفاده از متا تگ «noindex» است. این متا تگ یک دستورالعمل است که به خزندههای موتور جستجو دستور میدهد تا یک صفحه وب را ایندکس نکنند و بنابراین در نتایج موتور جستجو نشان داده نمیشود. در مقالهی «noindex چیست» دربارهی این تگ به طور کامل توضیح دادهایم.

نحوه اضافه کردن متا تگ «noindex»

تمام کاری که شما باید انجام دهید این است که برچسب زیر را در بخش کد منبع HTML یک صفحه وارد کنید:

<"meta name=”robots” content=”noindex>

در بعضی از CMSها (سیستم مدیریت محتوایی) درج این متاتگ سادهتر است. در وردپرس که به کاربران اجازه دسترسی به کد منبع را نمیدهد باید از افزونههای مانند Yoast SEO استفاده کنید. توجه داشته باشید که این تگ باید در تک تک صفحاتی که نباید ایندکس شوند قرار بگیرد.

به علاوه، اگر میخواهید گوگل صفحه شما را ایندکس نکند و همزمان لینکهای موجود در صفحه را نیز فالو نکند میتوانید از متاتگ «noindex» همراه با «nofollow» استفاده کنید:

<"meta name=”robots” content=”noindex,nofollow>

استفاده از سرچ کنسول

ابتدا باید سایت خود را در Google Webmaster Tools که اکنون Google Search Console نامیده میشود تأیید کنید تا به آنها ثابت کنید که شما واقعاً مالک وب سایت هستید. برای انجام این کار، به یک حساب گوگل نیاز دارید.

برای این کار ابتدا وارد Google Search Console شده و روی دکمه «add property» کلیک کنید. بعد از نصب گوگل سرچ کنسول با اضافه کردن تگ ارائه شده در DNS Configuration یا با معرفی گوگل آنالیتیکس مالکیت خود را تأیید کنید.

محدود کردن دسترسی به صفحه با robot. txt

رایجترین روش برای مسدود کردن دسترسی رباتها به صفحات سایت استفاده از فایل robots.txt است. به طور معمول همه رباتها و خزندهها به هر سایتی که میرسند، قبل از هر کاری ابتدا به دنبال این فایل میگردند و در صورت وجود، طبق دستورالعملهای موجود در آن عمل میکنند.

البته باید توجه داشته باشید در این مورد نیز گاهی اوقات رباتهایی هستند که به قوانین نوشته شده در فایل robots.txt توجهی نمیکنند یا حتی ممکن است از قوانین آن برای ایندکس نکردن پیروی کنند. اما در هر حال محتوای صفحه را بخزند و در سرور خودشان ذخیره کنند. پس اگر میخواهید محتوای خاصی را ایمن کرده و از رباتهای اینترنتی مخفی کنید، بهتر است از رمزهای عبور صفحه استفاده کنید.

فایل robots.txt فقط برای محدود کردن دسترسی رباتها کاربرد دارد و چنانچه فکر میکنید همه صفحات سایت شایستگی و ارزش ایندکس شدن توسط خزندههای گوگل را دارند، به این فایل نیازی نخواهید داشت. حتی نیازی به وارد کردن یک فایل خالی به همین نام نیست. برای درج یک فایل robots.txt باید به هاست دسترسی پیدا کرده و آن را در root ذخیره کنید.

اگر به هر دلیلی دسترسی شما به سرور محدود شده است، میتوانید دسترسی ربات به آن را با قرار دادن برچسبهای متا در هدر صفحه محدود کنید.

یک فایل ساده برای مدیریت رباتهای اینترنتی از دو قانون اساسی استفاده میکند که عبارتند از:

User-agent: نوع رباتی را نشان میدهد که نباید به صفحه دسترسی داشته باشد.

Disallow: آدرس صفحهای را که میخواهید از رباتها پنهان شود نشان میدهد.

- با ترکیب این دو دستور میتوانید قوانین مختلفی برای دسترسی به صفحات داخلی سایت تعریف کنید. به عنوان مثال، برای یک user-agent خاص، میتوان چندین آدرس را معرفی کرد، یا بالعکس.

- لیستی از همه رباتهای اینترنتی معتبر در پایگاه داده رباتهای وب موجود است. شما در مقابل User-agent نام هر رباتی که مد نظرتان هست را از لیست یاد شده پیدا کرده و بنویسید. اگر قصد دارید قانون خاصی را برای تمام رباتها وضع کنید باید در مقابل User-agent از نشانه * استفاده کنید. به مثال زیر توجه کنید:

User-agent: *

/Disallow: /folder1

موتور جستجوی گوگل دارای چند نوع ربات است که معروفترین آنها Googlebot نام دارد. این ربات وظیفه بررسی و ایندکس کردن صفحات وب را بر عهده دارد. ربات Gogglebot-image نیز وظیفه بررسی و ایندکس کردن تصاویر سایت را دارد.

User-Agent: Googlebot

/Disallow: /folder2

شما میتوانید قوانین خود را به روشهای مختلف اعمال کنید، میتوانید یک صفحه خاص یا گروهی از صفحات را برای یک قانون تعریف کنید.

سرچ کنسول گوگل برای نمایش صفحاتی از سایت که توسط robots.txt برای رباتها مسدود شده یک بخش اختصاصی دارد. این صفحه URL های مسدود شده یا Removal نامیده میشود و به عنوان زیر مجموعهای از بخش Crawl تعریف شده است.

- برای اطمینان از عملکرد صحیح فایل robots.txt، به قسمت URLهای مسدود شده در حساب مدیر وب سایت خود مراجعه کرده و محتویات فایل را در قسمت اول کپی کنید.

- در قسمت دوم، آدرس صفحاتی را که میخواهید محدودیت رباتهای گوگل در دسترسی به آنها را بسنجید وارد کنید. (یک آدرس در هر خط)

- در قسمت انتهایی میتوانید علاوه بر ربات اصلی که مسئول ایندکس کردن صفحات است، یک نوع ربات دیگر گوگل را نیز انتخاب کنید.

- با فشار دادن دکمه Test، نتایج آزمایش و میزان دسترسی رباتها به هر یک از این آدرسها برای شما نمایش داده میشود.

نحوه انتخاب صفحات معرفی شده در فایل robots.txt و مخفی کردن آنها از موتورهای جستجو ارتباط مستقیمی با سیاستهای انتشار محتوا و سئوی سایت شما خواهد داشت. قبل از ایجاد تغییرات اساسی در این فایل، حتماً از کارشناسان سئو مشاوره گرفته و کدهای وارد شده را چندین بار تست و بازنویسی کنید.

ابزار حذف url

سریعترین راه حذف url از گوگل استفاده از Google Removal Tool است:

https://www.google.com/webmasters/tools/url-removal

برای استفاده از این قابلیت، هنگامی که نام دامنه شما به طور رسمی در گوگل سرچ کنسول تأیید شد، باید موارد زیر را انجام دهید:

- مطابق شکل زیر روی «Index» و سپس «Removals» کلیک کنید:

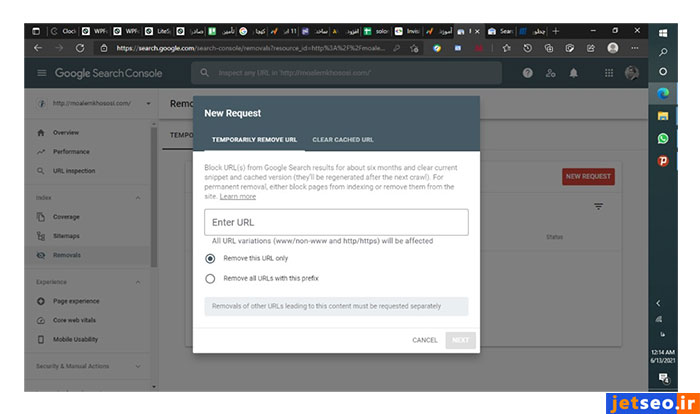

- سپس، بعد از کلیک روی «درخواست جدید»، باید روی دکمه «پنهان کردن موقت» کلیک کنید.

- URL را وارد کرده و روی «next» کلیک کنید.

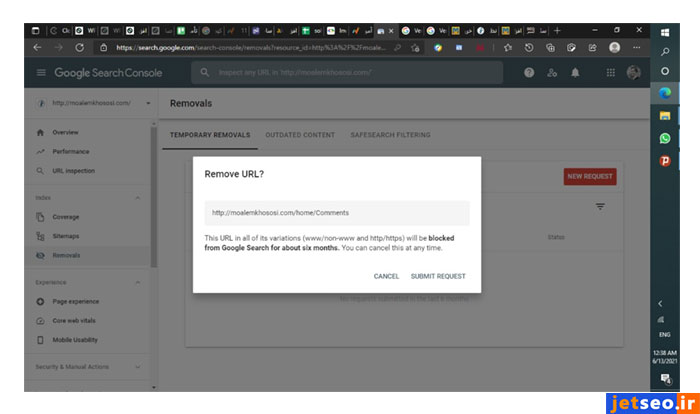

- در مرحله بعد، از شما سوال میشود که آیا واقعا میخواهید url را حذف کنید؟ «submit request» را انتخاب کنید:

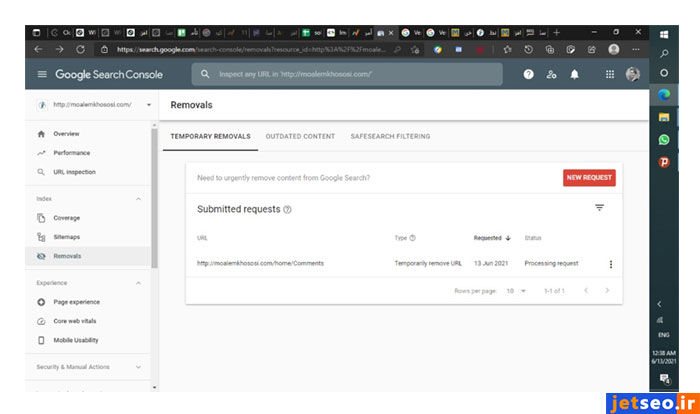

- بعد از انجام این درخواست، درخواست شما در صف پردازش قرار میگیرد:

هنگامی که صفحهای را با ابزار گوگل حذف کردید، به خاطر داشته باشید که فقط ۹۰ روز معتبر است. سپس، برای حذف صفحه از فهرست گوگل، باید دوباره از این ابزار استفاده کنید. بهتر است که یک یادآوری تقویم تنظیم کنید تا درخواست حذف خود را هر نود روز یک بار ثبت کنید.

استفاده از رمز عبور برای صفحات

اگر شناسه کاربری و گذرواژه خود را (برای مشاهده صفحه وب به آن نیاز دارید) در صفحه وب قرار دهید، خزندههای موتور جستجو نمیتوانند از ورود به سیستم برای خزیدن آن استفاده کنند. محافظت با رمز عبور از فایلهای موجود در سرور شما موتورهای جستجو را در مسیرهای خزیدن متوقف میکند. URLها قابل خزیدن، ایندکس شدن یا انتقال هیچ سیگنال رتبهبندی نیستند.

بهترین روش حذف صفحه index شده کدام است؟

روشهای گوناگونی برای حذف صفحات ایندکس شده از صفحه نتایج گوگل وجود دارد. برای پاک کردن موقت صفحات از نتایج جستجو میتوانید از ابزار حذف URL استفاده کنید اما برای حذف دائمی صفحات، روشهایی مانند استفاده از رمز عبور یا افزودن برچسب متا «noindex» میتوانند بسیار کمککننده باشند.

همه روشهایی که در بالا ذکر شد، میتوانند به شما در حذف یک صفحه از نتایج گوگل کمک کنند. کنترل اینکه چه صفحاتی در جستجو قابل مشاهده و کدام یک نباید در صفحه نتایج آورده شوند، به نوع محتوا، وبسایت و کسب و کار شما بستگی دارد. از کارشناسان جت سئو مشاوره بگیرید تا مطمئنترین راه را به شما پیشنهاد داده و به شما در انجام این کار تخصصی کمک کنند.

همچنین برای آنالیز سایت خود می توانید از ابزار جت سئو و افزونه جت سئو استفاده کنید. کافی است روی لینک زیر کلیک کنید و 7 روز رایگان از این ابزار استفاده کنید: